Auf dem Weg zu einer integrierten Datenanalysequalität: Kriterien für die Anwendung von Industrial Data Science

Von Datenqualität zu Datenanalysequalität

Die Anwendung von Industrial Data Science (IDS) im Kontext von vernetzten smarten Produkten erfordert die Modellierung und Strukturierung von Daten für deren Design, Entwicklung und Nutzung. Gerade bei smarten Produkten ist ein umfassender Umgang mit der Datenqualität aufgrund des interdisziplinären Charakters und des breiten Spektrums an heterogenen Stakeholder:innen über den gesamten Produktlebenszyklus zwingend erforderlich. Das übergeordnete Ziel der Datenaufbereitung ist es, qualitativ hochwertige Daten für die Anwendung und Auswertung durch die Nutzer:innen bereitzustellen. Etablierte Prozessmodelle für die industrielle Datenanalyse behandeln die Spezifikation und Sicherung der Datenqualität oft als eine einzelne Aktivität mit einem definierten Abschluss. Der Bereitstellung einer durchgängigen Datenqualität wurde im Bereich der industriellen Datenanalyse bisher wenig Aufmerksamkeit gewidmet. In diesem Beitrag werden wir (1) vier verschiedene Phasen zur Sicherstellung einer durchgängigen Datenqualität entlang von Datenanalyseaktivitäten strukturieren, (2) eine Reihe von Kriterien und Maßnahmen zur Erfüllung und Quantifizierung von Datenqualitätsanforderungen auf der Grundlage etablierter Kriterien definieren und (3) ein Schritt-für-Schritt-Modell zur Etablierung und Aufrechterhaltung einer hohen Datenqualität für IDS-Anwendungen bereitstellen. Die Qualitätskriterien zielen darauf ab, punktuelle und kontinuierliche Maßnahmen während des Datenanalyseprozesses zu identifizieren. Das heißt, sie zielen auf eine gemeinsame Verantwortung für die Aufrechterhaltung der Datenqualität während der Analyse zwischen Analyst:innen und Nutzer:innen ab. Das entwickelte Modell bietet einen praktikablen Ansatz zur Bewertung und Sicherstellung der Anforderungen an die Datenanalysequalität.

Diese Publikation ist das Ergebnis der Forschungsarbeit des Instituts für Produktionssysteme (IPS) der TU Dortmund und des Lehrstuhls für Virtuelle Produktentwicklung (VPE) der TU Kaiserslautern.

(1) Vier Schritte zur Kategorisierung der Kriterien der Datenanalysequalität

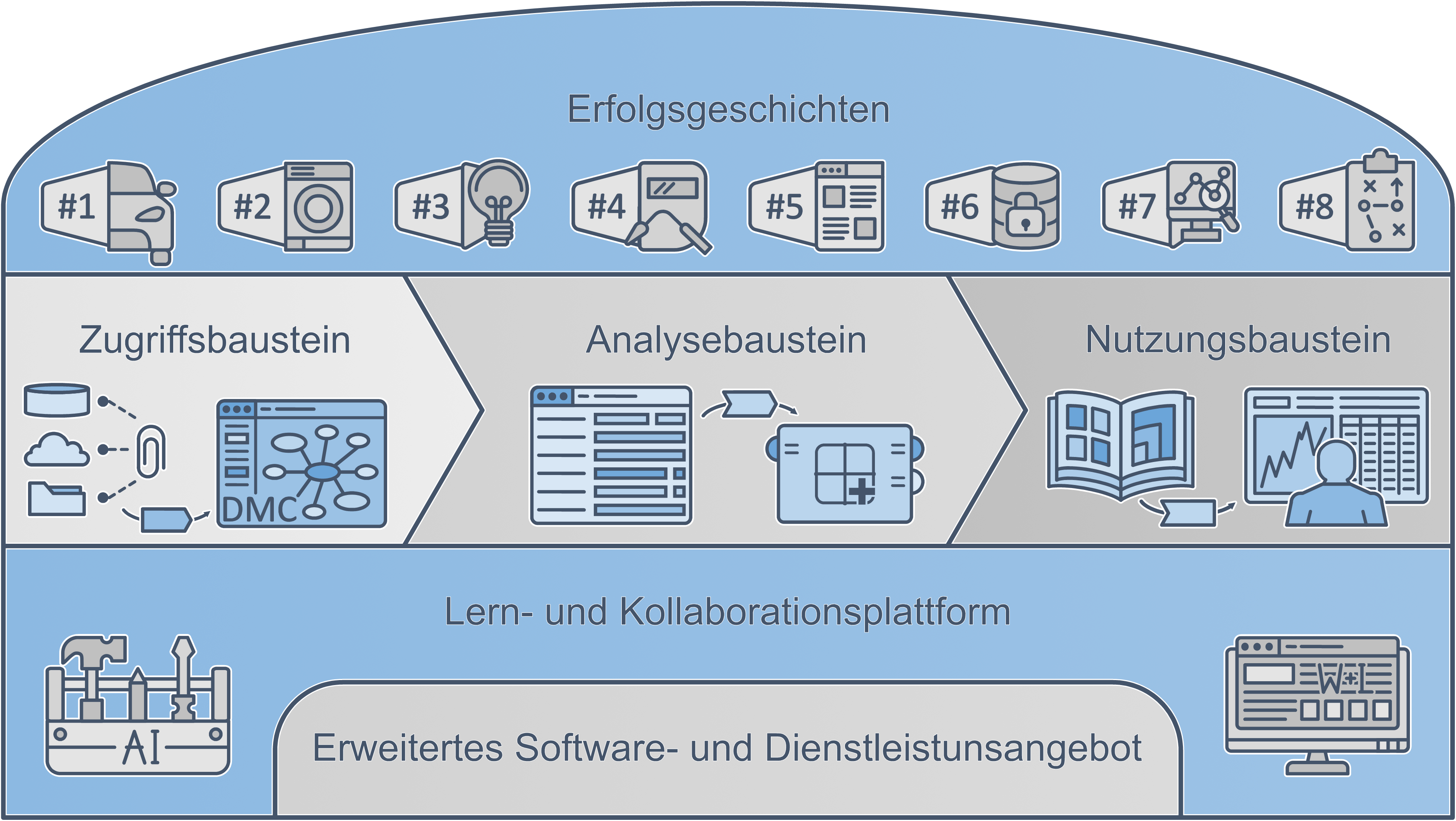

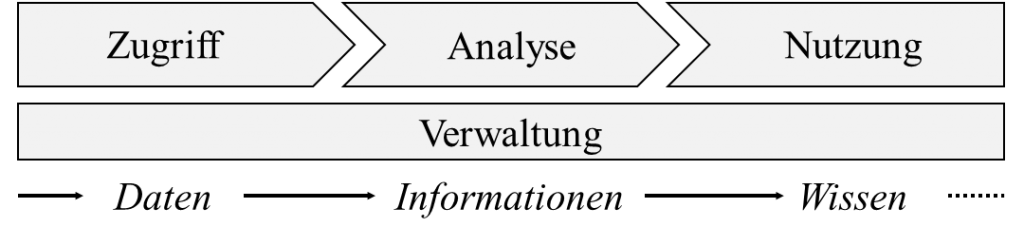

Industrial Engineering und IDS sind eng miteinander verwandt. Beide beinhalten ähnliche Schritte für faktenbasierte Entscheidungsprozesse. Der erste Schritt besteht darin, alle notwendigen Datenquellen zu erschließen, sodass die Bereitstellung der Daten in den folgenden Schritten gesichert ist. Der zweite Schritt ist die Analyse der Daten, um Informationen zu gewinnen. Im dritten Schritt wird darauf abgezielt, aus den gewonnenen Informationen einen wirtschaftlichen Nutzen zu erzielen. Dazu ist es notwendig, die Informationen im industriellen Anwendungsfall einzusetzen. Der vierte Schritt befasst sich mit der Verwaltung der peripheren Prozesse. Er unterstützt die ersten drei Schritten, sodass die industrielle Realität vollständig in diesem Modell abgebildet wird.

Abbildung 1: Prozesskette der industriellen Datenanalyse

(2) Zusammenstellung von Kriterien zur Messung der Datenqualität in der vorgestellten Prozessordnung

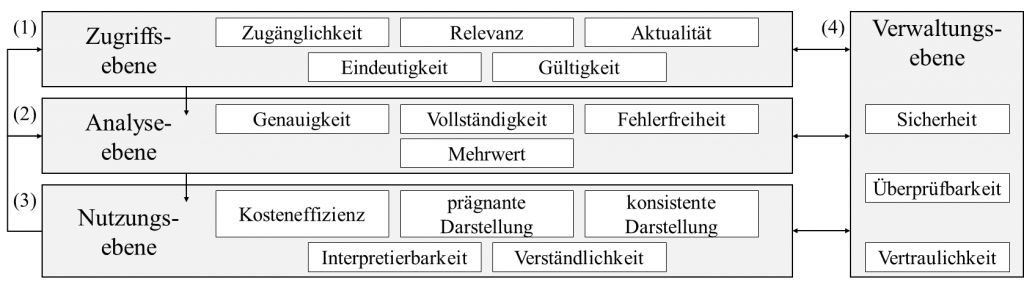

Die Zugriffsschicht umfasst Aspekte der Qualität der Rohdaten und der entsprechenden Geschäftsprozesse. Daraus ergeben sich die folgenden Kriterien: Zugänglichkeit, Relevanz, Aktualität, Eindeutigkeit und Gültigkeit der Daten. Die Analyseschicht bezieht sich auf die Qualität der Datenanalyse und befasst sich in erster Linie mit der Wissensgenerierung. Daraus ergeben sich die folgenden Kriterien: Genauigkeit, Vollständigkeit, Fehlerfreiheit und Zusatznutzen. Die dritte Ebene befasst sich mit der Anwendung der Daten in einem industriellen Umfeld und zielt darauf ab, eine hohe Qualität der Ergebnisse der Datenanalysen zu erreichen. Daraus ergeben sich folgende Kriterien: Kosteneffizienz, prägnante Darstellung, konsistente Darstellung, Interpretierbarkeit und Verständlichkeit. Die letzte Ebene befasst sich mit Fragen der Datenverwaltung. Sie umfasst folgende Kriterien: Sicherheit, Überprüfbarkeit und Vertraulichkeit.

(3) Prozessmodell für integrierte Datenanalysequalität

Die Sicherung der integrierten Qualität während der Schritte der industriellen Datenanalyse ist eine durchgängige Aufgabe. Anstelle von punktuellen Aktivitäten erfordert die Datenanalysequalität einen kontinuierlichen Prozess, der den Lebenszyklus von Daten, Informationen und Wissen umfasst. Die Kombination der vier Phasen industrieller Data Science-Projekte und die zugehörigen Kriterien finden sich in diesem Prozessmodell wieder.

Abbildung 2: Prozessmodell für die integrierte Datenanalysequalität

Schlussfolgerung und Ausblick

Die vorliegende Arbeit leistet einen Beitrag zur Entwicklung einer integrierten Datenanalysequalität in der Anwendung von IDS. Basierend auf etablierten Ansätzen zur Kategorisierung von Datenqualität wird ein organisatorischer Ansatz mit vier Ebenen im IDS-Prozess vorgestellt. Insgesamt ermöglicht das Rahmenwerk in Verbindung mit den Kriterien die Realisierung einer ganzheitlichen Datenqualitätsstrategie wie dem Total Data Quality Management. Wichtig ist jedoch, dass geeignete Maßnahmen eingeleitet werden, um eine nachhaltige Datenanalysequalität über den gesamten Produkt- oder Prozesslebenszyklus sicherzustellen und Qualitätsaspekte langfristig zu überwachen. Ein bewusster Umgang mit der Datenqualität von Anfang bis Ende sorgt für effizientere und erfolgreichere Analyseprojekte. Unabhängig davon, welche Kriterien oder Dimensionen letztendlich gewählt werden, ist es von wesentlicher Bedeutung, die sich verändernde Natur des Betrachtungsgegenstandes zu berücksichtigen, von verfügbaren Daten über neuartige Informationen bis hin zu wertschöpfendem Wissen.